Na hora de comprar uma TV nova ou na hora de bater uma foto, o HDR sempre está presente, mas nunca muito bem explicado.

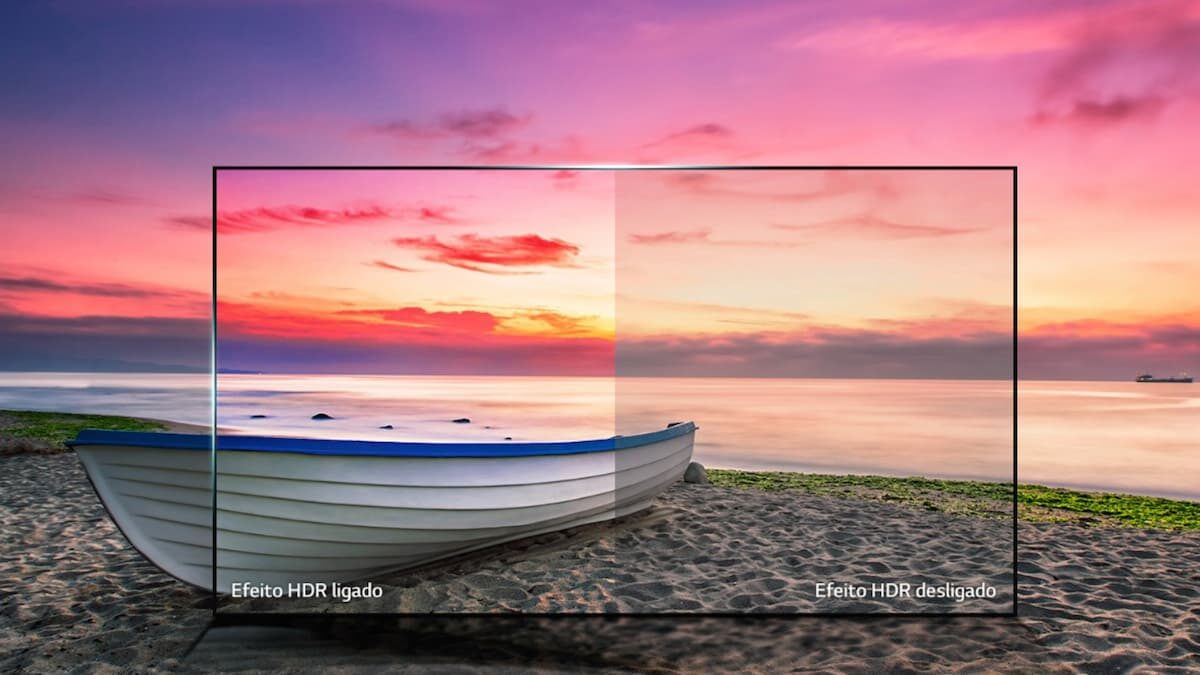

A tecnologia HDR (High Dynamic Range) revolucionou a forma como capturamos e visualizamos imagens, oferecendo uma experiência visual mais realista e rica em cores.

Ela atua expandindo a gama de luminosidade, revelando detalhes sutis em áreas claras e escuras, como resultado, temos fotos e vídeos com maior profundidade e clareza.

O objetivo dela, tanto na TV, como nas câmeras, é trazer uma dose extra de realismo e impacto visual em cada imagem apresentada.

A seguir você vai entender melhor como ela pode ser utilizada. Vem comigo!

A principal vantagem do HDR é a capacidade de capturar uma ampla gama de luminosidade em uma única imagem.

Com isso você consegue ter fotos e vídeos mais realistas e detalhados, onde tanto as áreas escuras quanto as claras mantêm seus detalhes visíveis.

Através dessa tecnologia, a experiência visual é enriquecida, trazendo destaque a nuances sutis à tona, além de trazer maior profundidade e contraste, elevando a qualidade das imagens.

» Veja também: As melhores TVs até R$ 2500

A tecnologia HDR nas TVs e monitores funciona utilizando metadados para aumentar o contraste entre as áreas claras e escuras.

O objetivo dela é trazer mais profundidade reproduzindo um volume maior de cores do que na faixa dinâmica padrão (SDR).

Dentro da tecnologia HDR há também algumas diferenças na forma do HDR utilizado:

Ou seja, independente da imagem, as cenas ensolaradas podem parecer excessivamente brilhantes, enquanto a sombra pode perder detalhes importantes.

Nesse caso temos o inverso do HDR10, as cenas escuras são reproduzidas com um pico de brilho menor, enquanto as mais claras podem ter um pico de brilho mais alto.

É exatamente essa diferença que traz mais realidade às imagens, a distinção da cor do pixel utilizada em cada ponto da cena.

Para que o HDR possa ser efetivo, também deve ser observado a quantidade de brilho que a tela suporta, valor medido em nits. Quanto maior o valor de nits, melhor.

Também existem alguns padrões de resposta do HDR de acordo com a tela da TV:

Um detalhe importante, caso você vá assistir conteúdos em HDR, tanto a tela deve suportar o HDR como a fonte do vídeo também fornecer o formato HDR como opção de reprodução.

Em caso de utilização de dispositivos externos, como consoles, para que o HDR possa ser exibido corretamente, a tela também precisa ser compatível com HDMI 2.0a ou versões superiores.

E claro, já existem conteúdos em HDR no mercado, é possível encontrá-los tanto em jogos, como na Netflix e em outras plataformas como YouTube, Disney+ e Prime Video.

Aos poucos o recurso está sendo adotado pelo mercado como um todo, enquanto isso não acontece, a conversão para o HDR será ligeiramente mais artificial.

Outro aspecto importante é que existem vários padrões de HDR no mercado que rivalizam entre si.

Os padrões mais comuns de serem encontrados nas TVs mais novas serão o HDR, HDR10, HDR10+ e o Dolby Vision, sendo que os modelos Dolby Vision serão mais caros pois a tecnologia é patenteada e deve ser licenciada.

Em geral, a resolução HDR10 já é muito interessante, sendo que a HDR10+ já seria uma excelente escolha caso você queira uma solução custo benefício pela qualidade de imagem.

» Veja também: As melhores TVs até R$ 3000

Quando falamos do HDR nas câmeras, o funcionamento é feito de forma diferente, apesar do conceito principal ser o mesmo: realçar o brilho e contraste contidos na imagem.

Ao tirar uma foto com o HDR ativado, várias fotos são tiradas ao mesmo tempo com todas as variações de luminosidade e brilho possíveis. Ao fim, o sistema une todas as fotos em uma única foto e gera a versão final com a melhor qualidade.

Esse processo é bastante útil ao tirar fotos de locais muito iluminados ou que tenham muito contraste e ajuda a balancear a imagem para que nenhuma cor fique “estourada”.

Praticamente todos os celulares hoje em dia dispõem da função HDR em suas câmeras, porém nem todos têm a mesma qualidade de HDR disponível.

Como a velocidade do sistema e a lente utilizada pela câmera pode mudar de modelo para modelo, os celulares mais fracos podem tirar cerca de 3 fotos antes de uni-las em uma única, sendo que os mais modernos podem tirar 5 ou mais.

No final, o objetivo é praticamente o mesmo do HDR da TV: trazer um equilíbrio entre os níveis de brilho com diferentes ajustes de iluminação, resultando em cores mais vivas e sombras mais acentuadas.

O HDR é muito útil nas fotografias em situações onde existe uma grande diferença de luminosidade entre as áreas claras e escuras da cena, como um pôr do sol em um horizonte escuro.

Existem duas ocasiões onde o HDR não é recomendado:

O HDR no celular é um recurso que combina várias fotos em diferentes níveis de brilho para capturar detalhes em áreas claras e escuras, melhorando a qualidade final das fotos.

O 4K e HDR não são diretamente comparáveis pois aprimoram a imagem de forma distinta. Enquanto o 4K se refere a resolução da imagem, o HDR aborda o aperfeiçoamento da imagem apresentada. É possível encontrar TVs e monitores com 4K com HDR juntos.

O HD se refere a uma resolução de imagem que melhora a nitidez. Já o HDR amplia o contraste e a gama de cores, aprimorando a qualidade final da imagem. Os recursos se somam. É possível ter, por exemplo, uma TV ou monitor HD com HDR.

O cabo HDMI 2.0a ou mais recente suporta a transmissão de conteúdo em HDR e a transmite com qualidade. Essa versão permite a transferência adequada das informações necessárias para a reprodução de imagens em alta faixa dinâmica.

Founder do Blog ReviewTV, entusiasta da tecnologia e do mundo tech geral. Com mais de 4 anos de conhecimento acumulado na área, fez do ReviewTV uma plataforma de transbordo de conhecimento.

Nosso site utiliza cookies para melhorar sua experiência. Ao continuar aqui, você concorda com nossos Termos de Uso e Política de Privacidade.